Besoin de lire vite ? 🏃⚡

Voici l’essentiel de l’article pour tout comprendre en 30 secondes chrono ! ⏱️

👉 TL;DR : Le Model Context Protocol (MCP) devient le standard pour connecter les LLMs et agents IA à des outils externes de manière propre, scalable et maintenable. Fini les intégrations manuelles complexes : MCP centralise l’accès aux API, outils métiers et services web via des serveurs standardisés. L’article présente ses cas d’usage, les avantages concrets (sécurité, modularité, scalabilité) et les principaux outils et frameworks pour l’adopter (Composio, OpenTools, PulseMCP, etc.).

En novembre 2024, Anthropic annonçait un tournant majeur dans l’écosystème de l’intelligence artificielle avec le lancement du Model Context Protocol (MCP). Ce protocole ouvert sous licence MIT, conçu pour standardiser la transmission de contexte vers les LLM (Large Language Models), vise à faire ce que l’USB-C a fait pour les périphériques : créer une connexion universelle, fiable et modulaire. Mais que se cache-t-il réellement derrière cet acronyme ? Pourquoi tout l’écosystème IA semble-t-il s’y intéresser ? Et comment le MCP pourrait transformer vos outils et workflows ? LabSense vous explique tout.

🧩 Un besoin fondamental : donner du contexte aux LLMs

Par défaut, un LLM comme GPT ou Claude ne peut pas exécuter de code, appeler une API, ou interagir avec une application métier en temps réel sans une infrastructure d’intégration contextuelle. C’est pourquoi sont apparues des solutions comme :

- Composio, qui propose une bibliothèque de toolkits et un protocole MCP pour connecter plus de 100 outils dans des IDEs comme Cursor ou Claude.

- Agents.json, une tentative de standardisation par-dessus les API d’OpenAI — intéressante, mais peu adoptée à ce jour.

- MCP, aujourd’hui reconnu comme l’approche la plus structurée, puissante et adoptée pour faire circuler le contexte métier entre outils et IA.

🧠 Le MCP, qu’est-ce que c’est ?

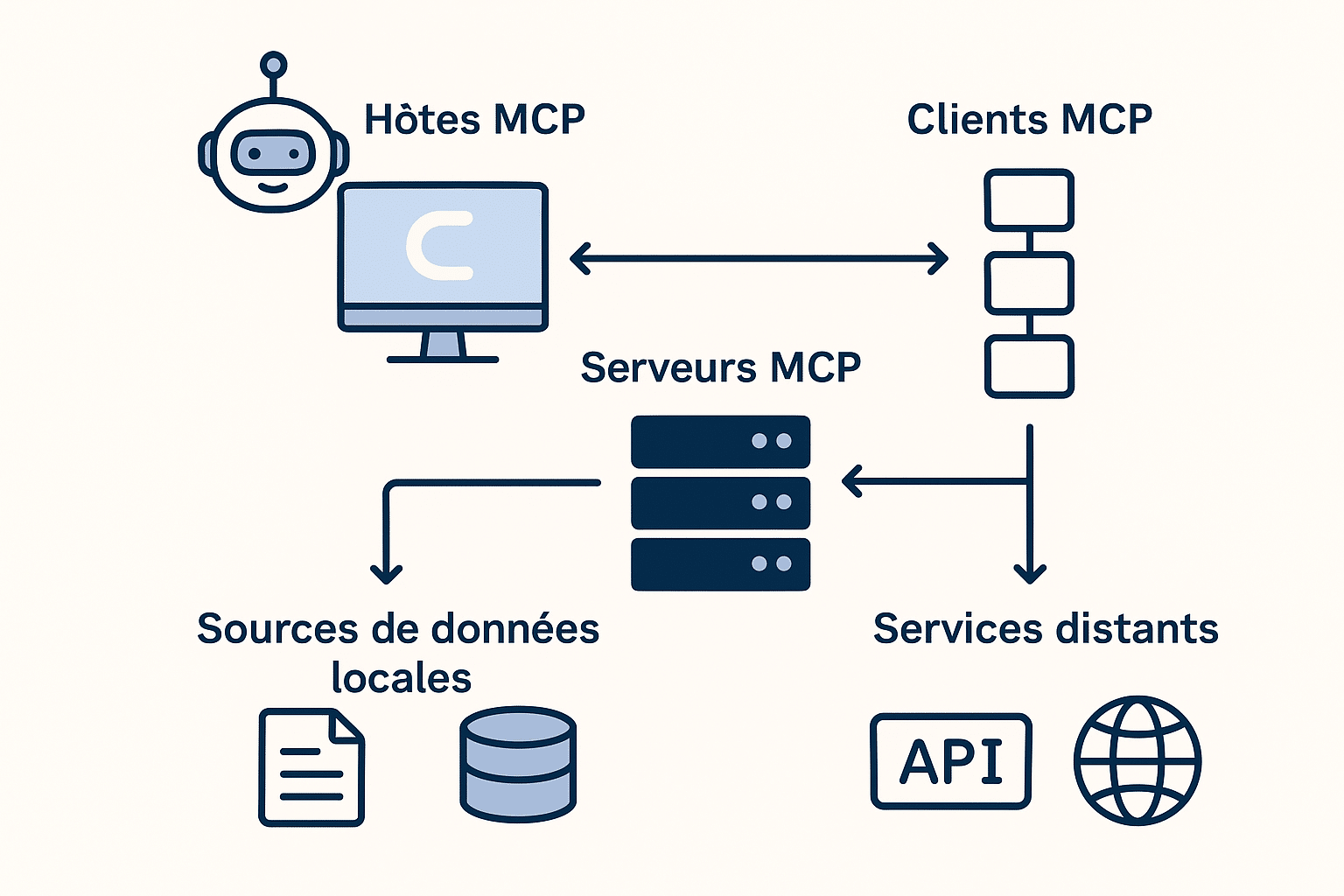

Le Model Context Protocol est un protocole de communication standardisé permettant de connecter les LLMs à des données structurées, des outils métier, et des modèles de prompts. Il repose sur une architecture client-serveur et utilise JSON-RPC 2.0 pour assurer les échanges entre :

- L’hôte : l’application qui dialogue avec le LLM (ex. Claude Desktop, Copilot Studio).

- Le client MCP : le connecteur qui interagit avec les serveurs.

- Le serveur MCP : qui expose des données ou outils (base de données, API, fichiers locaux…).

L’objectif ? Fournir du contexte aux modèles pour qu’ils génèrent des réponses plus pertinentes, tout en facilitant les intégrations dans les écosystèmes professionnels existants.

Comment ça fonctionne, concrètement ?

MCP repose sur trois types d’objets standardisés pour structurer le contexte : les ressources, les outils et les prompts structurés. Ces composants rendent l’IA plus utile, contextuelle et capable d’agir directement dans les environnements métiers. Prenons l’exemple d’un agent IA dans une application RH. Grâce à MCP, il peut :

- Interroger une base de données interne (serveur MCP)

- Utiliser un outil pour envoyer des notifications aux collaborateurs

- Générer des réponses contextualisées (prompts guidés)

Le tout sans avoir à construire des intégrations sur mesure ! Le MCP devient ainsi une passerelle universelle entre les LLMs et les données de votre entreprise.

Une infrastructure pensée pour la scalabilité des agents IA

L’intégration de chaque outil manuellement à un agent IA est fastidieuse, fragile et difficile à maintenir. Lorsque vous avez besoin de 10, 50 ou 100 outils (Slack, Notion, HubSpot, Salesforce, Jira, etc.), cette complexité explose.

MCP agit comme un registre centralisé et standardisé de ces outils, permettant aux agents IA de les appeler dynamiquement. Il existe deux types de serveurs MCP selon le mode de communication :

- SSE (Server-Sent Events) pour des services distants accessibles via HTTP.

- STDIO, pour exécuter localement des outils via I/O standard (pratique en ligne de commande ou sur serveur local).

Grâce à cette architecture, un assistant peut comprendre une requête comme : « Envoie ce document à l’équipe finance sur Slack, programme une réunion avec Claire-Marie et remplis le rapport trimestriel dans Notion. » Et exécuter cette tâche, via un ou plusieurs serveurs MCP, sans que vous ayez besoin de coder manuellement les intégrations pour chaque outil.

📈 Une adoption fulgurante en quelques mois

À son lancement, MCP soulevait quelques interrogations : limité aux modèles Anthropic, sécurité encore floue, compatibilité restreinte… Pourtant, en moins de six mois, l’écosystème s’est rapidement structuré autour de cette norme :

- Des géants comme Microsoft, IBM, Stripe, OpenAI, JetBrains et Cisco ont rejoint le projet. Microsoft l’a adopté dans Copilot Studio, simplifiant la création et la maintenance des agents connectés aux sources internes.

- Des outils clés comme Replit, Codeium, Spring Framework, ou Docker maintiennent déjà des implémentations compatibles MCP, pour fournir aux LLMs un meilleur contexte dans les environnements de développement.

- OpenAI a intégré MCP dans son SDK pour agents en mars 2025.

- Block, de son côté, l’utilise pour connecter ses agents IA aux systèmes internes en toute transparence.

« MCP est passé d’une lueur dans les yeux de Justin Spahr-Summers et David Soria Parra […] à un standard ouvert florissant avec des milliers d’intégrations » — Mike Krieger, Chief Product Officer chez Anthropic

À lire aussi

Agents IA : pourquoi les entreprises ne pourront bientôt plus s’en passer

« Quand on parle IA, les chiffres sont toujours vertigineux. D’ici 2028, le marché mondial de l’IA devrait atteindre 500 milliards de dollars, tandis que celui des chatbots dépassera 47,1 milliards de dollars en 2030… » >> Lire la suite

GPT-4.1, l’arme secrète d’OpenAI pour les développeurs et les entreprises

« Une nouvelle fois, OpenAI a créé la surprise ! Le 14 avril 2025 ont été dévoilés trois nouveaux modèles d’intelligence artificielle : GPT-4.1, GPT-4.1 mini et GPT-4.1 nano. Ces modèles, exclusivement accessibles via l’API d’OpenA … » >> Lire la suite

Llama 4 Scout, Maverick et Behemoth : quoi de neuf du côté de l’IA multimodale by Meta ?

« Le 5 avril 2025, Meta a frappé fort en dévoilant les premiers modèles de sa série Llama 4, conçus pour être nativement multimodaux. Leurs noms ? Scout et Maverick. Ils seront bientôt rejoints par le géant Behemoth… » >> Lire la suite.

Pourquoi le MCP devient la norme industrielle

Adopter MCP, c’est plusieurs bénéfices qu’il devient de plus en plus difficile d’ignorer :

- Une architecture propre et modulaire : chaque outil est encapsulé dans un composant standardisé.

- Un contrôle d’accès robuste : grâce à des systèmes d’authentification intégrés (OAuth, Google, etc.).

- Une scalabilité native : ajouter ou retirer un outil se fait sans redéployer le système.

- Une communauté active : des registres comme Composio Registry, PulseMCP, Smithery ou OpenTools proposent des milliers d’intégrations prêtes à l’emploi.

- Un support officiel des grands acteurs comme Microsoft et Open AI.

Quels changements pour l’IA générative ?

Les LLMs ont besoin de contexte pour fonctionner de façon pertinente. MCP vient combler ce vide.

✅ Interopérabilité

On peut changer de fournisseur de modèle sans tout reconstruire.

✅ Sécurité renforcée

Avec la gestion des droits via OAuth 2.1, les flux d’échange sont mieux protégés.

✅ Écosystème modulaire

Des SDK sont déjà disponibles pour Python, Java, C#, Kotlin, TypeScript… et bientôt PHP, Ruby.

« MCP aide les développeurs à se concentrer sur la création, plutôt que sur l’infrastructure » — Zankar Desai, Microsoft

🗃️ Le MCP mis en oeuvre : cas d’usages

Des centaines d’agents utilisent aujourd’hui MCP, avec des cas concrets dans les domaines suivants :

Support client automatisé : les IA peuvent lire une base de tickets (via un serveur MCP connecté à Zendesk ou Intercom), extraire les requêtes fréquentes et générer des réponses contextualisées.

Agent de développement : des IDE comme Cursor ou Windsurf intègrent nativement MCP pour que les agents IA puissent accéder à la documentation d’entreprise, automatiser des pull requests, ou suggérer des modifications dans le code.

Scraping et traitement d’informations : via des outils MCP comme OpenTools, les agents peuvent interroger des sites web, récupérer des données météo, comparer des produits, ou faire de l’analyse financière à partir de sources en ligne.

Assistant RH : l’IA peut scanner les calendriers, analyser les performances (avec un serveur connecté à Google Sheets ou Notion) et suggérer des plannings ou décisions RH via des intégrations MCP.

💡 Le saviez-vous ?

Les modèles Allready, la plateforme IA de LabSense, utilisent les derniers LLM de pointe. Ils peuvent vous aider à booster les performances de votre contenu, qu’il s’agisse d’annonces immobilières, d’articles ou de fiches produits. Les tester, c’est les adopter !

🔌 MCP : le futur de l’IA est déjà branché

Le Model Context Protocol est en passe de devenir l’élément central des architectures d’agent IA évolutives. Il permet une séparation claire entre logique d’agent et accès aux outils, tout en assurant sécurité, modularité et maintenabilité. Dans un marché où les agents IA deviennent la norme, il est essentiel de pouvoir les connecter rapidement, proprement et de manière sécurisée à vos données. Le Model Context Protocol pose les bases d’une interopérabilité durable et ouverte, répondant aux besoins des développeurs comme des grandes entreprises. Pour les entreprises qui veulent tirer parti de l’IA générative dans leurs workflows métiers, intégrer MCP dès aujourd’hui est un investissement stratégique.

💡 LabSense, votre partenaire pour tirer parti de l’IA et du MCP

Chez LabSense, nous intégrons les dernières avancées de l’IA dans vos contenus métiers grâce à plus de 10 ans de R&D, 400 millions de textes générés, et une expertise unique en données enrichies (OpenData, météo, POI, etc.). Vous souhaitez intégrer des agents IA dans votre système ou comprendre comment MCP peut accélérer vos flux de production ? Parlons-en !

👉 Contactez nos experts dès aujourd’hui pour en savoir plus !