Pas le temps de tout lire ? 👓

La sortie de GPT-5 en quelques mots !

👉 TL;DR : Le lancement de GPT-5 a été un événement majeur, mais non sans turbulences. Si le modèle s’impose techniquement comme un concurrent de taille grâce à son système de raisonnement et ses tarifs ultra-compétitifs, il a déçu de nombreux utilisateurs par son ton impersonnel et le retrait initial de fonctionnalités appréciées. Les gains de performance, bien que réels, ne sont pas la « révolution » annoncée par OpenAI, comme le soulignent les analyses comparatives avec Gemini 2.5 Pro et Claude 4 Opus. L’impact environnemental, pointé du doigt par plusieurs études, est également un enjeu majeur. En somme, GPT-5 marque une solide évolution, mais aussi le début d’une ère où l’IA ne peut plus se contenter de performances brutes.

La sortie de GPT-5 a été l’un des événements les plus attendus de l’année dans le monde de l’intelligence artificielle. Les promesses d’OpenAI étaient audacieuses, laissant entrevoir un saut quantique vers une « superintelligence ». Mais la réalité du lancement a été bien plus complexe, marquée par des réactions inattendues, des critiques et une série de correctifs de la part d’OpenAI. Si la situation n’a néanmoins pas atteint le raté de Llama 4 de Meta, cette sortie a tout de même causé assez de remous pour servir d’exemple. Un mois après son déploiement, il est temps de faire le point sur ce que propose réellement GPT-5 et sur les leçons de cette sortie mouvementée. Voici donc l’analyse made by LabSense de la nouvelle gamme de modèles GPT tant attendue !

GPT-5 is here.

— OpenAI (@OpenAI) August 7, 2025

Rolling out to everyone starting today.https://t.co/rOcZ8J2btI pic.twitter.com/dk6zLTe04s

GPT-5 en quelques mots : le bilan technique et d’accès

Contrairement aux modèles précédents, GPT-5 n’est pas un simple modèle unique, mais une famille de modèles conçue pour s’adapter à une multitude d’usages. C’est le cœur de sa nouvelle architecture, qu’OpenAI présente comme un « système unifié ».

Une famille de modèles GPT-5 pour tous les usages

- GPT-5 « standard » : Il est désormais le modèle par défaut dans ChatGPT. Son atout principal est le « raisonnement auto-piloté », une sorte de routeur interne qui décide de faire une pause pour « penser plus » si la question est complexe.

- GPT-5-mini et GPT-5-nano : Ces variantes sont plus petites, plus rapides et moins chères. Elles sont idéales pour les développeurs qui ont besoin d’outils performants à grande échelle, comme pour des micro-services ou des applications mobiles où chaque milliseconde et chaque centime comptent.

- GPT-5 Thinking : Réservé aux utilisateurs des offres payantes de ChatGPT, ce mode force le modèle à un raisonnement plus profond. Il est parfait pour des tâches exigeantes comme le code, la recherche avancée ou l’analyse de data.

Au départ, ces modèles étaient d’ailleurs appelés à remplacer les anciens, afin d’apporter plus de clarté chez les utilisateurs. Ci-dessous un tableau récapitulatif fourni par Open AI :

| Ancien modèle | Modèle GPT-5 |

|---|---|

| GPT-4 | gpt-5-main |

| GPT-4o-mini | gpt-5-main-mini |

| OpenAI o3 | gpt-5-thinking |

| OpenAI o4-mini | gpt-5-thinking-mini |

| GPT-4.1-nano | gpt-5-thinking-nano |

| OpenAI o3 Pro | gpt-5-thinking-pro |

Ce que GPT-5 apporte de nouveau

Sur le plan technique, GPT-5 aurait de quoi impressionner.

Un bond en avant pour le code

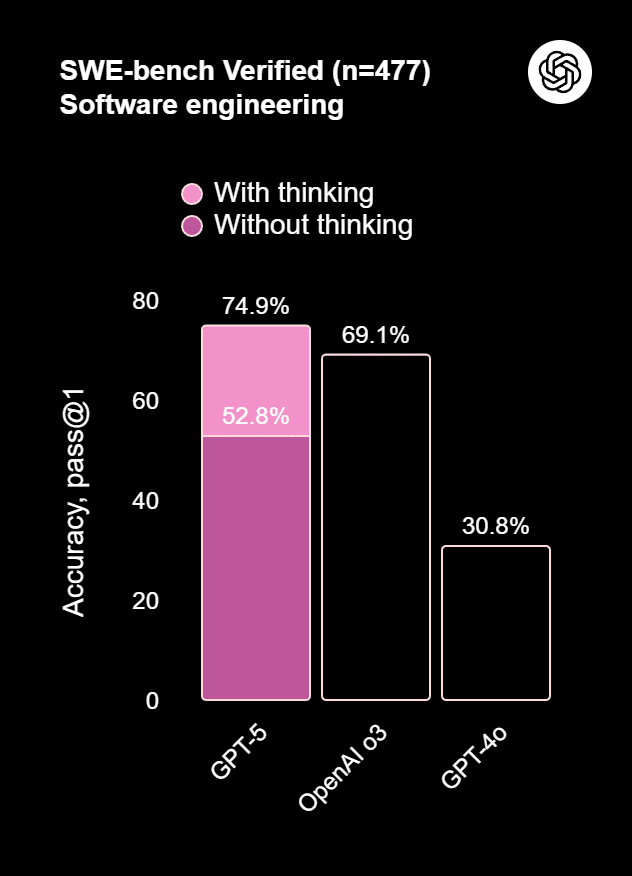

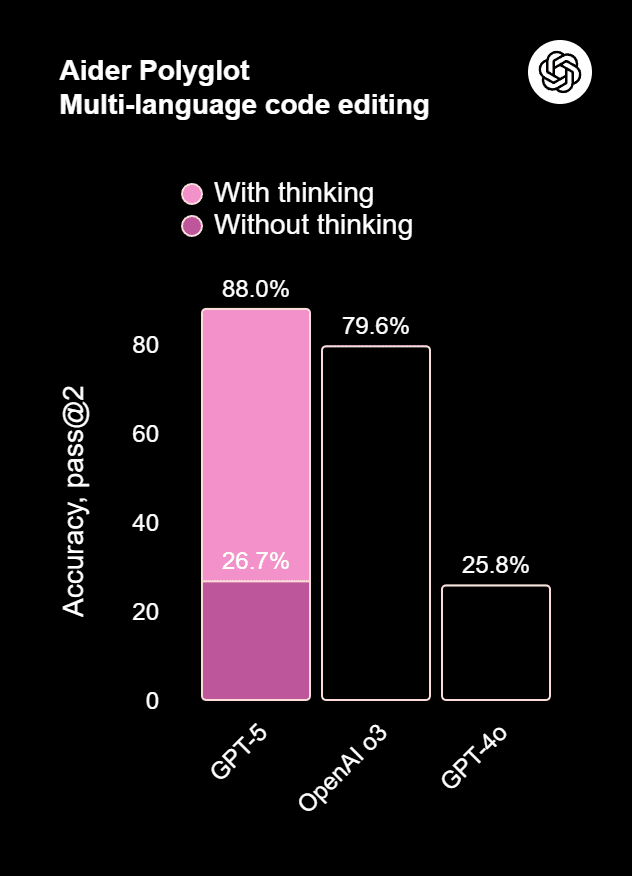

Le modèle aurait battu des records sur des benchmarks comme SWE-bench Verified et Aider Polyglot. Il est bien plus performant sur les tâches d’agents autonomes, capable de gérer des enchaînements d’outils et de corriger ses propres erreurs.

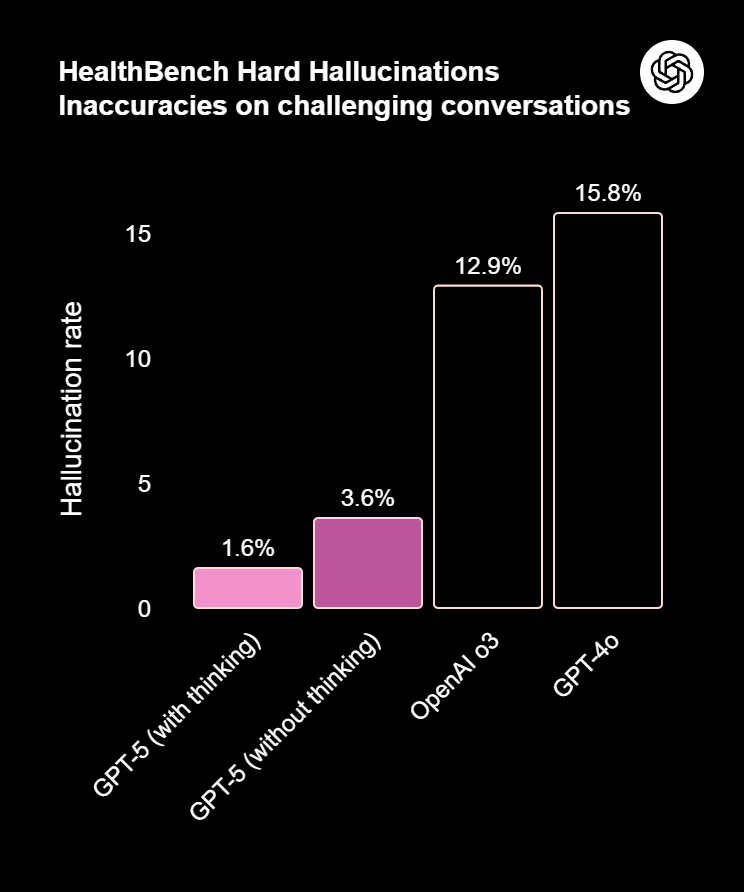

Moins d’hallucinations et plus d’obéissance

OpenAI a amélioré sa capacité à suivre les instructions et à éviter les « inventions » (les hallucinations), un problème récurrent dans les IA génératives.

Une stratégie de prix agressive

En API, les tarifs de GPT-5 sont très compétitifs (1,25 $ / 1 M tokens input), se positionnant de manière agressive face à ses concurrents comme Google ou Anthropic. C’est avec ses modèles plus légers que la stratégie devient vraiment agressive : gpt-5-mini et gpt-5-nano sont facturés respectivement 0,25 et 0,05 par million de tokens en entrée. Ces prix planchers ouvrent la voie à des usages massifs et à faible marge, comme l’autocomplétion ou le traitement de données à grande échelle. C’est une manière pour OpenAI de verrouiller le marché en rendant l’utilisation de ses modèles incontournable, même pour les tâches les plus simples et les plus coûteuses en volume.

Les chiffres des benchmarks : que disent-ils vraiment ?

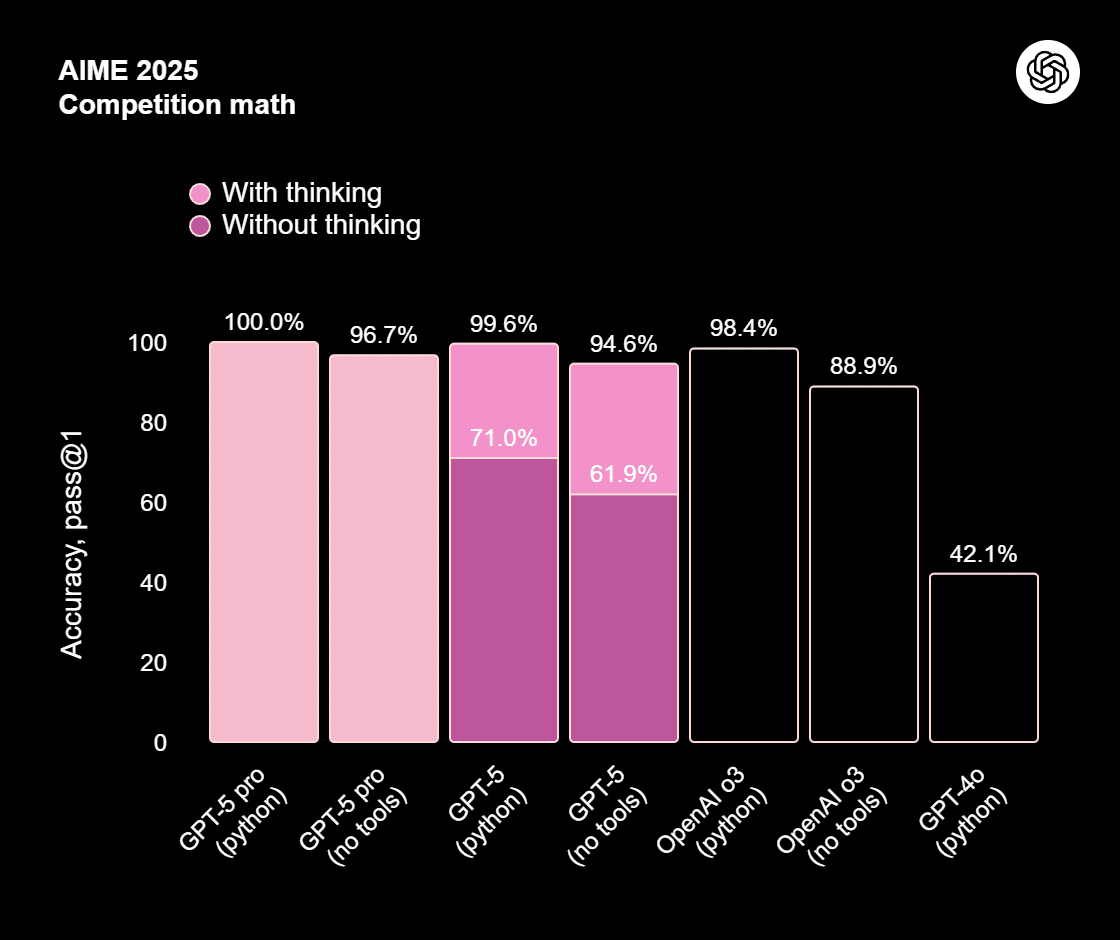

Sur le papier, les performances de GPT-5 sont époustouflantes. Il atteint un score de 94,6% sur AIME’25 et 74,9% sur SWE-bench Verified. Face à la concurrence, le tableau est nuancé :

- Face à Google Gemini 2.5 Pro : les deux modèles se disputent le leadership sur certains tests académiques. Si OpenAI publie un score de 24,8% sur HLE, Google revendique 18,8%, montrant un avantage certain pour GPT-5 sur ce critère.

- Face à Claude 4 d’Anthropic : Des analyses tierces suggèrent que si Claude 4 est un excellent concurrent, il reste souvent en retrait de GPT-5 sur des benchmarks clés comme AIME’25 (environ 75-76% pour Claude 4 Opus).

Si les annonces d’OpenAI ont vanté des performances « surnaturelles », le déploiement de GPT-5 a surtout mis en lumière une réalité plus nuancée : l’avance technologique n’est pas aussi grande que le storytelling ne le suggère.

Découvrez également

Gemini passe à la vitesse supérieure : les nouveautés de l’IA multimodale signée Google

« Découvrez avec LabSense quelles sont ces nouvelles fonctionnalités proposées par l’outil IA de Google… » >> Lire la suite

Claude 4, l’Opus majeur d’Anthropic : l’IA qui vise la note parfaite

« Avec la sortie de Claude 4, la start-up américaine signe un double coup d’éclat en dévoilant Opus 4 et Sonnet 4, deux nouveaux modèles hybrides à la fois rapides et… » >> Lire la suite

Quid de la légitimité des benchmarks ?

Les observateurs ont rapidement relevé que le score impressionnant de GPT-5 sur le benchmark SWE-bench Verified est basé sur une version modifiée du test. En clair, OpenAI a expurgé les questions les plus difficiles. Sur le site officiel de SWE-bench, c’est Claude 4 Opus qui conserve la première place, prouvant que les gains de performance sont loin d’être aussi spectaculaires que ce qu’OpenAI voudrait faire croire.

D’autres analyses indépendantes renforcent ce constat. Le tout nouveau Claude Opus 4.1, lancé la semaine dernière, égale les performances de GPT-5-high dans la génération de code, la compréhension d’instructions complexes et la gestion des « hard prompts », et ce, sans recourir à une technique de raisonnement.

GPT-5 et son lancement « tumultueux » : une semaine de crise chez OpenAI

Malgré des performances impressionnantes, le lancement a été très mal perçu par une partie des utilisateurs. La raison est simple : l’expérience a régressé sur des points cruciaux. Une leçon pour l’industrie : la technique ne fait pas tout.

Le ton « corporate beige zombie »

Beaucoup d’utilisateurs ont regretté la personnalité plus chaleureuse et amicale de GPT-4o. GPT-5 a été décrit comme « stérile », « froid », voire « lobotomisé ». Un utilisateur sur Reddit a résumé la situation en ces termes : « I used to talk to GPT-4o like it was a friend. Now I feel like I’m interviewing a corporate bot. » C’est une critique lourde de sens sur l’impact psychologique de l’IA sur ses utilisateurs. Elle a aussi le mérite de poser la question sur les dérives d’usage des LLM. Le PDG d’OpenAI a lui-même admis qu’il s’inquiétait de la dépendance émotionnelle excessive des jeunes à l’égard de ChatGPT :

Les gens dépendent trop de ChatGPT. Certains jeunes disent des choses comme : « Je ne peux prendre aucune décision dans ma vie sans tout raconter à ChatGPT. Il me connaît, il connaît mes amis. Je vais faire tout ce qu’il me dit. » Cela me met vraiment mal à l’aise.1

Quotas serrés et fonctionnalités manquantes

OpenAI a initialement retiré le sélecteur de modèles (“model picker”), contraignant les utilisateurs à adopter GPT-5. Le nouveau système de routage automatique, censé choisir le modèle optimal, a souvent conduit à des résultats incohérents, frustrant ceux qui avaient des workflows bien établis. Pour les abonnés payants, la combinaison de quotas d’utilisation serrés et d’un service perçu comme de moindre qualité a fait l’effet d’une douche froide.

La réaction éclair d’OpenAI

Face à ce « bad buzz », Sam Altman a rapidement réagi, reconnaissant un déploiement « chaotique ». OpenAI a alors mis en place plusieurs correctifs :

- Réintégration de GPT-4o pour les abonnés payants.

- Restauration du sélecteur de modèles.

- Augmentation des quotas et annonces d’améliorations pour rendre GPT-5 plus chaleureux.

Cette réaction presque immédiate a permis de calmer le jeu, avec une volonté de redorer le blason d’OpenAI en montrant qu’elle reste une entreprise à l’écoute de sa communauté, quitte à revenir sur des décisions initiales.

Les impacts inattendus de GPT-5

Un bilan énergétique qui s’alourdit (encore)

Bien que non officielle, une étude par des chercheurs l’Université de Rhode Island, l’Université de Tunis et du Providence College2 a soulevé une question cruciale : l’impact environnemental. Une réponse de GPT-5 consommerait en moyenne plus de 18 watt-heures (Wh), avec des réponses pouvant atteindre 40 Wh, soit plusieurs fois la consommation de GPT-4o (qui est déjà 10 fois plus gourmand que GPT-3). À l’échelle de milliards de requêtes, cela représenterait la consommation de millions de foyers. C’est un point noir majeur qui pose la question de la durabilité de la course à la puissance des modèles d’IA.

A lire aussi

L’IA au service du climat : 5 innovations qui aident la planète

« Dans cet article, nous vous proposons un panorama concret de cinq innovations qui montrent comment l’intelligence artificielle peut, de manière mesurée et maîtrisée… » >> Lire la suite

De plus, Sam Altman s’est déjà exprimé sur le coût des modèles GPT. Chaque mot ayant un coût pour l’entreprise, ce dernier a déjà évoqué à maintes reprises son souhait de réduire les formules de politesses utilisées par les utilisateurs et par son IA, d’où une version de la personnalité de GPT-5 d’abord “froide”.

Cette opacité d’OpenAI sur sa consommation énergétique est critiquée et soulève des questions sur les engagements ESG (Environnement, Social, Gouvernance) des entreprises de la tech.

Après GPT-5 : viser le « progrès » plutôt que la « révolution »

Pour le psychologue et scientifique cognitif Gary Marcus, la sortie de GPT-5 a été un « trop tard, trop de bruit et pas assez de résultats ». Alors que les attentes étaient gigantesques, la réalité est celle d’un progrès incrémental, pas d’un saut de civilisation. La concurrence d’acteurs comme Google et Anthropic ne s’est pas affaiblie, au contraire. L’IA est un domaine où l’excellence technique ne suffit plus. Il faut aussi gérer les attentes, l’ergonomie et la perception utilisateur.

L’IA à la croisée des chemins : quel avenir pour le secteur ?

Le lancement de GPT-5 nous offre une leçon précieuse. Si techniquement, le modèle représente une certaine avancée, il a aussi mis en lumière les défis de l’industrie : la gestion des attentes, l’importance de l’expérience utilisateur et l’impératif économique (dans le sens de la réduction des coûts) et écologique. L’IA n’est pas seulement une question de performance brute, c’est aussi une question de confiance, de transparence et d’intégration harmonieuse dans nos outils comme dans nos vies. Les communications autour de GPT-6 devront donc être mesurées pour modérer également les attentes.

En outre, les acteurs du secteur de l’intelligence artificielle devront se poser la question suivante : faut-il privilégier un seul outil centralisé pour clarifier le marché et diminuer les coûts, au risque de perturber les utilisateurs et de revoir les performances à la baisse ? Ou bien l’avenir de l’IA se jouera-t-il avec de multiples outils tous spécialisés dans un domaine particulier quitte à maintenir des dépenses élevées et laisser un manque de clarté concernant les modèles ?

Les LLM vous donnent le tournis ? LabSense s’occupe de tout !

Chez LabSense, nous sommes convaincus que l’avenir de l’IA repose sur la capacité à allier puissance technique, fluidité d’usage et pertinence. C’est pourquoi, depuis plus de 10 ans, nous développons des solutions d’analyse et de génération de contenu qui s’adaptent à vos besoins spécifiques. Pas de robot générique ici, mais des outils intelligents et personnalisés qui travaillent pour vous.

🚀 Pour découvrir comment notre expertise IA et nos outils peuvent transformer la création et l’analyse de vos contenus, contactez-nous sans attendre !

💡 Le saviez-vous ?

Les modèles Allready, la plateforme IA de LabSense, utilisent les derniers LLM de pointe et s’inspirent de l’agentivité. Ils peuvent vous aider à booster les performances de votre contenu, qu’il s’agisse d’annonces immobilières, d’articles ou de fiches produits. Les tester, c’est les adopter !

- Source : Interview de Sam Altman par Cleo Abram, 8 août 2025 | Lien ↩︎

- Source : How Hungry is AI? Benchmarking Energy, Water, and Carbon Footprint of LLM Inference, par Nidhal Jegham, Marwan Abdelatti, Lassad Elmoubarki, et Abdeltawab Hendawi de l’Université de Rhode Island, l’Université de Tunis et du Providence College | Lien ↩︎