Un aperçu éclair de l’article ⚡

Quels outils permettent de générer des vidéos IA de qualité en 2026 ?

👉 TL;DR : La génération vidéo par IA a atteint en 2026 un niveau de maturité qui la rend exploitable par les professionnels. Grâce aux progrès en cohérence temporelle, en compréhension physique du monde et en contrôlabilité, les outils se spécialisent par usage : création cinématographique (Runway), animation de personnages (Kling), post-production mobile (Higgsfield), contenu social vertical (Sora 2) et publicité produit sécurisée (Veo 3.1). Le marché évolue vers une logique de stack d’outils plutôt que vers une solution unique.

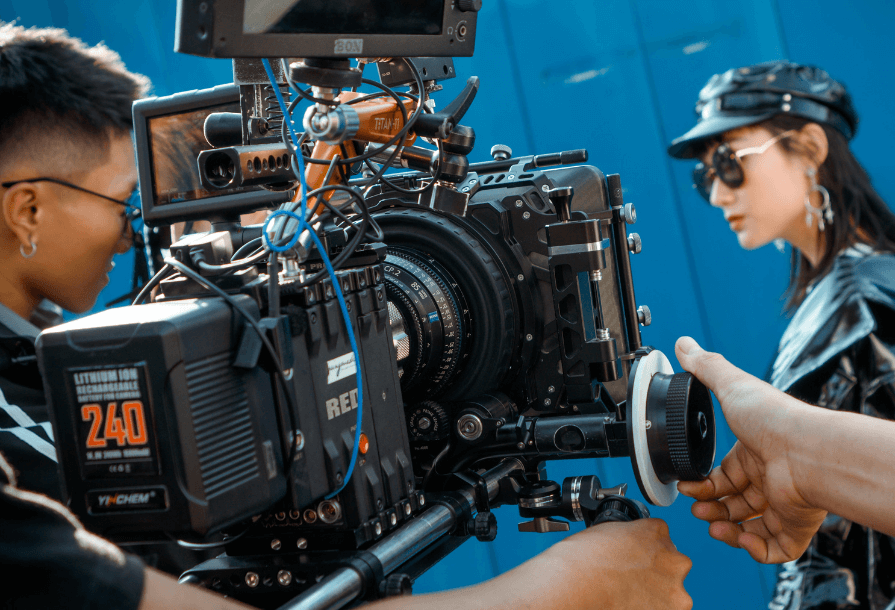

Si l’IA générative réussit toujours son « effet wow », générer des vidéos IA produit les résultats les plus impressionnants. Ainsi, en l’espace de deux ans, la génération vidéo par intelligence artificielle est passée du statut de curiosité technologique à celui d’outil de production crédible. En effet, ce qui relevait encore récemment de l’expérimentation visuelle est désormais utilisé pour concevoir des publicités, des contenus sociaux, des films ou des supports de communication à grande échelle.

En 2026, la question n’est donc plus de savoir si l’IA peut générer de la vidéo, mais comment et pour quels usages précis. C’est pourquoi, cette fois-ci, LabSense vous propose un décryptage du paysage actuel de la vidéo générée par IA. Découvrez (ou redécouvrez) cinq IA de génération de vidéos qui en mettent plein la vue ! 🎬

Comment la génération vidéo par IA transforme la production audiovisuelle 📺

En 2026, la génération vidéo par intelligence artificielle a atteint un niveau de maturité qui la rend enfin exploitable par les professionnels. Longtemps perçue comme spectaculaire mais imprévisible, elle repose désormais sur des avancées technologiques. Celles-ci ont d’ailleurs profondément transformé la fiabilité, la cohérence et le contrôle des vidéos produites. Trois ruptures majeures expliquent ce basculement.

Comprendre les IA vidéo : de la simple animation à la simulation physique réaliste

Pour commencer, si les formats text-to-video, image-to-video et video-to-video restent les points d’entrée les plus visibles, la véritable avancée réside dans la capacité des modèles récents à développer une compréhension implicite en trois dimensions du monde réel. En effet, s’entraînant sur des volumes massifs de données vidéo, ces IA ne se contentent plus d’animer des pixels. Elles apprennent à simuler la gravité, les mouvements, la lumière et les interactions entre objets, produisant alors des vidéos non seulement réalistes visuellement, mais aussi physiquement crédibles.

Qu’accomplissait la génération vidéo par IA il y a un an ?

Génération de vidéo par IA : 5 nouveaux modèles qui bouleversent le secteur

« Parmi les innovations les plus marquantes de ces derniers jours, des géants comme Meta, Alibaba et ByteDance dévoilent des technologies révolutionnaires… » >> Lire la suite

Cohérence temporelle et fin des artefacts pour des vidéos fluides et professionnelles

Ensuite, l’un des principaux freins à l’adoption professionnelle de la vidéo générée par IA était l’incohérence temporelle. Elle était souvent visible à travers des visages instables ou des objets changeant d’apparence au fil des images. Les architectures actuelles ont largement résolu ce problème en intégrant une mémoire sémantique des éléments présents dans la scène. Cette dernière permet ainsi de garantir la stabilité de leur forme, de leur texture et de leur identité tout au long de la séquence, y compris lors d’occlusions ou de mouvements complexes.

NanoBanana et la cohérence visuelle, de l’image à la vidéo

NanoBanana ou GPT-1.5 Image : quel modèle IA d’image choisir ?

« Le paysage de l’IA générative en cette fin d’année 2025 a franchi un cap structurel. Après une longue phase d’exploration esthétique, les modèles d’image… » >> Lire la suite

La “contrôlabilité” comme nouveau standard

Pour terminer, le véritable tournant de 2026 réside dans la contrôlabilité des outils de génération vidéo par IA. Là où les premières solutions fonctionnaient de manière largement aléatoire, les professionnels exigent désormais un contrôle précis sur les mouvements de caméra, le timing des actions, l’orientation des sujets ou encore l’éclairage. Cette capacité à générer des vidéos de façon déterministe permet à l’IA de s’intégrer dans des workflows de production structurés, transformant ces technologies en outils industriels plutôt qu’en simples démonstrations créatives.

Produisez des vidéos IA de qualité cinématographique grâce à Runway 🎥

Basée à New York, Runway incarne l’archétype de la startup « deep tech » créative. Une levée de fonds massive de 308 millions de dollars en série D (avril 2025) a porté sa valorisation totale à plus de 3 milliards de dollars. De plus, l’entreprise dispose des ressources pour entraîner ses modèles qu’elle qualifie de « general world models »1. En revanche, contrairement à d’autres qui visent le grand public, Runway construit des outils qui visent à aider les cinéastes et les artistes.

2 fonctionnalités phares pour maîtriser parfaitement la caméra

Avec son modèle Gen-4.5, Runway offre un niveau de précision inédit :

- Director Mode (mode réalisateur) : fini les prompts vagues comme « zoom in ». Cette interface permet par exemple de paramétrer la caméra virtuelle avec des valeurs numériques précises. Vous pouvez entre autres définir un Zoom, un Pan ou un Tilt, tout en découplant le mouvement de la caméra de celui du sujet. Vous pouvez réaliser des plans complexes, comme un Dolly Zoom (travelling compensé), impossibles à générer par simple texte.

- Motion Brush (pinceau de mouvement) : c’est une innovation majeure pour l’image-to-video. Plutôt que de décrire un mouvement, vous « peignez » les zones à animer. Vous pouvez faire couler une rivière vers le bas tout en faisant défiler des nuages vers la droite, laissant les montagnes parfaitement immobiles.

Exemple de cas d’usage : la prévisualisation (Previs) pour le cinéma, les clips musicaux et la création de plans artistiques nécessitant une mise en scène rigoureuse.

Avec Kling AI, animez des personnages réalistes en quelques clics 👨💻

Issu de la R&D de Kuaishou Technology, le géant chinois de la vidéo courte, Kling AI a connu une adoption fulgurante. Moins d’un an après son lancement en juin 2024, le service a atteint 100 millions de dollars de revenus annualisés (ARR) dès mars 2025. Sa force réside dans son accès illimité à des données de mouvements humains réels via l’écosystème Kuaishou.

La révolution du Motion Transfer

Kling (v2.6) domine le marché sur l’animation de personnages grâce à une compréhension quasi-biologique de la cinématique :

- Motion Transfer (transfert de mouvement) : cette fonctionnalité permet d’animer une image statique en utilisant une vidéo de référence. L’IA extrait le « squelette » du mouvement (danse, arts martiaux, discours) et l’applique à votre personnage. Elle a récemment fait beaucoup parler d’elle, car les résultats sont bluffants de réalisme.

- Préservation de l’identité : c’est le point fort de Kling. Contrairement à ses concurrents qui déforment souvent les visages lors de mouvements rapides, Kling maintient les traits du visage et la texture des vêtements avec une fidélité impressionnante.

We’re not prepared for how quickly production pipelines are going to change with AI.

— Justine Moore (@venturetwins) January 14, 2026

Some of the latest video models have immediate implications for Hollywood – endless character swaps at a negligible cost.

(this is from ederxavier3d on IG using Kling Motion Control) pic.twitter.com/CEwOGCHogW

Exemple de cas d’usage : animer des personnages historiques, créer des avatars virtuels réalistes pour la formation et la vente, ou transposer des chorégraphies virales sur des images fixes pour les réseaux sociaux.

Higgsfield ou la post-production mobile des générations vidéos IA simplifiée 🎬

Fondée par Alex Mashrabov (ancien responsable de l’IA générative chez Snap), Higgsfield vise une cible différente : les créateurs sociaux et le marketing mobile. Il s’agit ici d’une plateforme mettant à disposition des marques et des créateurs différents modèles d’IA (Kling, Sora, etc.) et ses propres outils, notamment un véritable studio cinéma. Elle fait régulièrement des publications chocs grâce à ses performances toujours plus perfectionnées.

Relight rééclaire vos scènes comme en studio (et la lumière fut !)

Et si vous pouviez corriger ou modifier la lumière après le tournage ou la génération ? Grâce à Relight, rien de plus simple. Avec une analyse de la profondeur 3D de l’image, l’outil permet de changer l’éclairage d’une scène comme si vous étiez en studio. Via un pad directionnel 3D, vous pouvez déplacer la source lumineuse, choisir entre une lumière « douce » (softbox) ou « dure » (soleil).

Pour les marques, l’outil permet également d’entrer des codes hexadécimaux pour obtenir une couleur de lumière correspondant exactement à leur charte graphique. Pratique si vous avez peu de moyens pour vous procurer un éclairage pro, si votre charte graphique évolue ou si vous souhaitez retoucher l’atmosphère d’une scène.

this why Hollywood is terrified of AI

— el.cine (@EHuanglu) January 6, 2026

this new AI Relight tool on Higgsfield can simulate film studio and change the source light direction, colour, exposure and even softness

AI is taking over film studios

here's how to use it: pic.twitter.com/mWbU3rlsJe

Exemple de cas d’usage : Higgsfield joue également pleinement sur les capacités de son outil et la tendance actuelle des réseaux sociaux en proposant directement de créer son avatar / influenceur IA.

Générer du contenu viral vertical pour smartphones avec Sora 2 📱

Avec la sortie de Sora 2 fin septembre 2025, OpenAI a opéré un pivot stratégique majeur. Ce n’est donc plus seulement un modèle de recherche accessible via une API, c’est une application sociale autonome (« Sora App ») disponible sur iOS et Android, conçue pour concurrencer directement TikTok et Instagram Reels.

Créez directement du contenu viral pour smartphone !

- Format vertical natif (9:16) : l’IA est optimisée pour générer des vidéos pleines pour smartphones, avec un cadrage intelligent qui garde les sujets au centre de l’attention lors du défilement.

- Cameos & Remix : l’aspect social est central. La fonction « Cameos » permet aux utilisateurs de créer un avatar numérique d’eux-mêmes (après vérification biométrique) pour s’insérer dans les vidéos. La fonction « Remix » permet de prendre une vidéo virale du flux et d’en générer une variation instantanée.

Exemple de cas d’usage : la création de contenu viral, de mèmes, le divertissement grand public et le Personal Branding (« Moi dans un film de science-fiction »).

En savoir plus sur la nouveauté de Sora 2

Rétrospective IA générative 2025 : LabSense fait le point !

« Mais la véritable rupture est venue de Sora 2 (une plateforme sociale qui permet de produire par IA des contenus audio-visuels prêts à publier)… » >> Lire la suite

La précision publicitaire augmentée avec Veo 3.1 🎯

Développé par l’élite de la recherche chez Google DeepMind, Veo 3.1 est la solution « Premium » intégrée à l’écosystème Workspace et YouTube. Ce dernier se distingue par sa capacité à générer en résolution 4K et par sa compréhension multimodale avancée.

Des vidéos produit 100 % conformes et réalistes avec « Ingredients to Video »

Veo s’attaque par exemple au cauchemar des marques : l’hallucination des produits (imaginez que l’IA génère une voiture qui ressemble à la vôtre, mais avec les mauvaises jantes, ou une canette avec du texte mal reproduit).

- Ingredients to Video : cette fonction permet d’injecter des images de référence multiples (exemple : Image A = le produit exact, Image B = le style artistique). Ces images agissent comme des contraintes inviolables pour l’IA.

- Brand Safety : le modèle génère une vidéo où le produit apparaît exactement tel qu’il est, sans déformation, tout en interagissant naturellement avec le sujet.

Exemple de cas d’usage : la publicité programmatique, les fiches produits e-commerce de luxe et les contenus d’entreprise nécessitant une fidélité absolue à la réalité.

Quelle IA vidéo choisir selon vos besoins en 2026 ? 🤔

| Critère | Runway (Gen-4.5) | Kling AI (v2.6) | Higgsfield | Sora 2 | Veo 3.1 |

| Fonction Clé | Director Mode (Caméra) | Motion Control (Transfert) | Relight (Éclairage) | Social Feed & Cameos | Ingredients to Video |

| Public Cible | Artistes, Studios, VFX | Prosumers, Asie | Créateurs réseaux sociaux | Grand public (Gen Z) | Agences pub, YouTube |

| Format Vertical | Supporté (Cadrage manuel) | Supporté | Natif (Mobile First) | Natif (Social Feed) | Supporté (Shorts) |

| Technologie | World models | Reconstruction squelettique | Depth mapping 3D | Diffusion latente | Multimodal (Images + Texte) |

| Modèle Éco. | Abonnement SaaS / Crédits | Abonnement / Crédits | Freemium / Abonnement | Gratuit (Beta) / Sub | Intégré (Google One/Workspace) |

Générer des vidéos IA avec éthique : l’enjeu pressant de la sécurité ⚖️

Avec la puissance de ces outils vient une responsabilité critique. Générer des vidéos IA n’est plus seulement amusant, ou anodin. En 2026, l’industrie commence enfin à se structurer pour garder la confiance des utilisateurs et garantir leur sécurité.

Le scandale des deepfakes, un risque qui nous concerne tous

Pour commencer, l’impact des deepfakes2 dépasse désormais le simple risque de désinformation. En ce début 2026, la riposte s’organise sur deux fronts. Tout d’abord juridique : l’acteur Matthew McConaughey a officiellement déposé son image et sa voix pour contrer l’usage non autorisé3, suivant la voie tracée par Scarlett Johansson. Loin d’être technophobe (il investit dans l’IA vocale avec ElevenLabs), il impose pour son image une logique de contrôle et de rémunération.

Connaissez-vous le secteur des IA vocales ?

Le boom des IA vocales : quand les machines ont du répondant

« La voix est en train de devenir l’une des interfaces les plus naturelles entre l’humain et la machine. Dans un monde saturé de texte et d’écrans, la parole ouvre… » >> Lire la suite

Ensuite, l’impact est aussi sociétal : la menace pèse une nouvelle fois lourdement sur les femmes et les mineurs. Une tribune récente de collectifs féministes (dont Osez le féminisme!) qualifie l’IA de « nouvelle ennemie », dénonçant entre autres les dérives d’outils comme Grok qui permettent la génération d’images dénudées non consenties et véhiculent des fantasmes rétrogrades. L’enjeu de 2026 n’est plus seulement de savoir « si c’est vrai », mais de protéger l’intégrité physique numérique des individus.

La bataille de la transparence des générations IA de vidéo : C2PA vs SynthID

Deux standards s’affrontent pour certifier l’origine du contenu. Mais leur application et leur efficacité sont encore discutables et perfectibles.

- C2PA (OpenAI, Runway) : dans l’idéal, ce standard ajoute des métadonnées cryptographiques au fichier (« Content Credentials »). C’est une carte d’identité numérique qui signale « je suis une IA », mais qui peut être perdue si le fichier est compressé.

- SynthID (Google) : une approche plus robuste qui insère un filigrane invisible directement dans les pixels de l’image. Résistant aux modifications, il permet à Google de détecter ses propres créations avec une fiabilité quasi totale.

La génération vidéo par IA entre créativité et responsabilité

En 2026, générer des vidéos IA dépasse la simple innovation technique. Elle exige de penser l’industrie dans son ensemble, entre créativité, contrôle et responsabilité. En outre, transparence, traçabilité, protection des identités et régulations locales deviennent autant de facteurs stratégiques que la qualité visuelle. L’avenir de la production audiovisuelle repose donc sur un équilibre délicat, ouvrant la voie à des standards et pratiques durables pour tous les acteurs de la chaîne de valeur.

Par conséquent, les IA vidéo ne sont plus de simples outils. Elles redéfinissent la manière dont nous créons, partageons et sécurisons le contenu audiovisuel. Comprendre et intégrer ces enjeux éthiques et techniques sera alors la clé pour rester compétitif et responsable dans ce nouvel écosystème.

Chez LabSense, nous accompagnons les entreprises et créateurs à exploiter pleinement les outils pour générer des vidéos IA. De l’évaluation des modèles les plus adaptés à votre workflow à l’optimisation des processus de production, nous vous aidons à naviguer dans l’écosystème complexe des IA vidéo et à tirer parti de ce qui est aujourd’hui possible, en fonction de vos besoins spécifiques et de vos contraintes opérationnelles.

Découvrez comment LabSense peut vous aider à sélectionner les meilleurs modèles d’IA vidéo et à structurer vos workflows pour exploiter pleinement le potentiel de la génération vidéo par IA. Contactez-nous !

- Les « world models » sont des réseaux neuronaux qui comprennent la dynamique du monde réel, y compris les propriétés physiques et spatiales. ↩︎

- « Technique basée sur l’intelligence artificielle, qui permet de créer des trucages ultraréalistes (ou hypertrucages) d’images, de vidéos et de sons, à des fins de fraude, de désinformation et de cyberharcèlement ; contenu créé avec cette technique. » Définition du Larousse || Lien ↩︎

- Source : « Matthew McConaughey Trademarks Himself to Fight AI Misuse », par Ben Fritz pour le Wall Street Journal, le 13 janvier 2026 || Lien ↩︎