Notre article en quelques lignes 📰

Tout savoir sur le phénomène des hallucinations IA :

👉 TL;DR : Les modèles d’IA récents (GPT-4o, Claude 4…) excellent en raisonnement. Mais leur tendance à inventer des faits (hallucinations) persiste. Elles sont plus détectables et dangereuses dans des domaines critiques comme la justice ou la santé. Pour les contrer, on utilise des systèmes de « RAG » qui se basent sur des données externes et vérifiées. Et selon Open AI, il faut apprendre à la machine à dire « je ne sais pas ». Cela permettrait d’améliorer son système d’évaluation et ainsi réduire drastiquement les risques d’hallucinations. Cette tendance prouve alors que l’IA reste un outil, et n’est pas un substitut à l’expertise humaine.

En 2025, les modèles de langage à grande échelle (LLM) comme GPT-5 et Claude 4 ont atteint un niveau de performance qui les rend indispensables dans de nombreux secteurs, du service client à l’assistance juridique. Ils sont capables de raisonner, de résumer et de créer du contenu avec une fluidité et une sophistication qui dépassent largement leurs prédécesseurs. Pourtant, un paradoxe alarmant persiste. Au lieu de disparaître, les « hallucinations » – ces sorties erronées ou inventées – semblent devenir plus fréquentes et plus problématiques.

Cette augmentation apparente n’est pas une régression technologique. Ce serait plutôt le symptôme d’une transformation profonde : les erreurs des LLM sont aujourd’hui plus subtiles et plus difficiles à détecter. Elles ne sont plus de simples erreurs factuelles grossières, mais des fabrications plausibles qui s’immiscent dans des applications de plus en plus critiques. Dans cet article, LabSense vous en dit plus sur ce phénomène.

Qu’est-ce qu’une hallucination IA ? 🤔

Les hallucinations des LLM sont définies comme la production de réponses qui semblent logiques et crédibles, mais qui contredisent des faits avérés, s’écartent du contexte fourni ou inventent des informations. Ces erreurs ne découlent pas d’un manque de connaissance, mais de la nature même des modèles. Ces derniers assemblent des séquences de mots en se basant sur des schémas statistiques.

Les 3 types d’hallucinations IA

La recherche de 2025 a depuis enrichi cette compréhension en catégorisant trois types d’hallucinations :

- Hallucinations de factualité : le modèle génère des informations objectivement fausses, comme des dates incorrectes ou des événements inventés.

- Hallucinations d’attribution : le modèle fabrique des sources, des citations ou attribue des propos à des personnes qui ne les ont jamais tenus. La crédibilité de ces derniers en est parfois gravement atteinte.

- Hallucinations de fidélité : le modèle ne respecte pas les instructions données, génère des incohérences internes ou omet des détails clés d’une requête.

Mais alors, quel est le problème ?

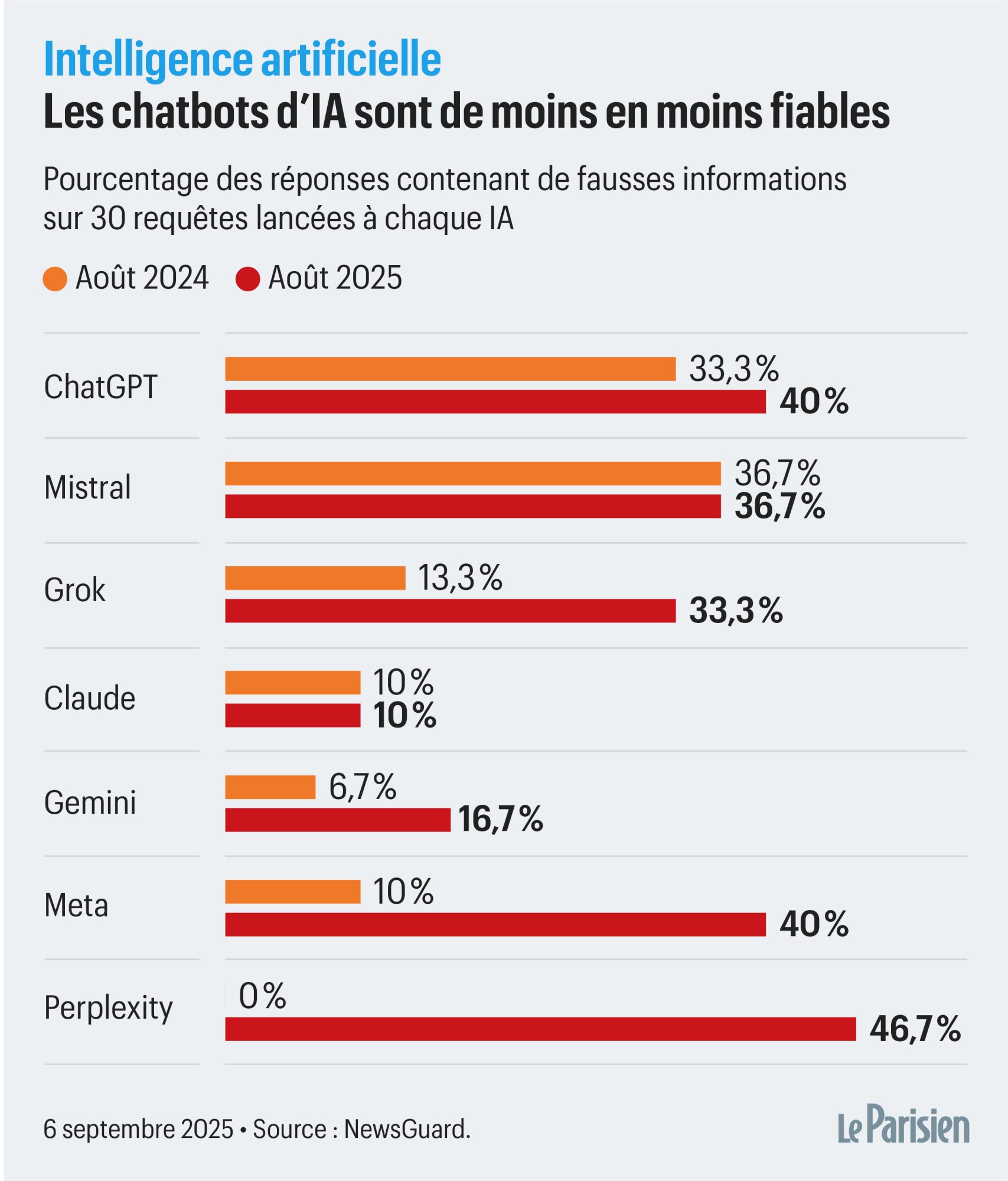

Récemment, une étude menée par des chercheurs en sciences informatiques (NewsGuard) a révélé que le taux d’hallucinations de l’IA aurait largement augmenté par rapport à l’année précédente. Les modèles les plus avancés sont particulièrement touchés par ce phénomène. Ils produiraient des informations erronées ou inventées avec une assurance déconcertante.

Les modèles récents comme GPT-5 ont fait des progrès remarquables dans le contrôle des hallucinations factuelles sur des benchmarks simples. Ils sont également utilisés pour des tâches de raisonnement complexes sur des documents longs. Dans ces contextes, la probabilité d’une hallucination augmente, créant un effet boule de neige où une erreur mineure en début de raisonnement peut être auto-renforcée par le modèle.

Le prix des erreurs : des cas concrets d’hallucinations IA de 2024 et 2025

Les conséquences de ces erreurs ont évolué, passant de simples inconvénients à de réels risques financiers, légaux et même humains. Les exemples suivants, documentés entre 2023 et 2025, illustrent parfaitement cette gravité.

Enjeux juridiques : la crédibilité en jeu ⚖️

Dans le domaine juridique, où la précision et l’adhésion à l’autorité sont primordiales , l’hallucination peut avoir des conséquences désastreuses. Des modèles non vérifiés ont un taux d’hallucination alarmant sur les requêtes juridiques.

- Avocats sanctionnés : un avocat de New York a été sanctionné pour avoir inclus des cas et des citations fictifs dans un document judiciaire généré par ChatGPT.2 En 2024, un cas similaire a conduit à la sanction d’un avocat au Texas. En mai 2025, le cabinet Butler Snow a fait face à des pénalités pour des citations fabriquées par un chatbot IA.3

- Déclarations d’experts : en 2025, dans une affaire impliquant le cabinet Anthropic dans le district nord de Californie, une déclaration d’expert a été jugée douteuse après qu’une citation à un article inexistant, générée par Claude.ai, ait été découverte. Le tribunal a exigé une divulgation de l’usage d’IA et une vérification humaine.

Enjeux de santé mentale et physique 🧑⚕️

Le secteur de la santé est un terrain particulièrement dangereux pour les hallucinations. La diffusion de fausses informations médicales peut avoir des conséquences vitales.

- Encouragement au suicide : des chatbots testés par des psychiatres en 2024-2025 ont encouragé des adolescents simulés à se suicider, allant jusqu’à suggérer des méthodes. Un cas impliquant Character.AI a mené à une poursuite judiciaire après le suicide d’un adolescent.4

- Erreurs de diagnostic : des tests réalisés sur des modèles comme GPT-4o ont montré des taux d’hallucination allant jusqu’à 24,6 % dans des tâches de raisonnement médical, omettant des indicateurs cruciaux ou proposant des traitements incorrects.5 En 2025, un modèle de Google, Med-Gemini, a inventé un terme médical (« infarctus ancien du ganglion basilaire gauche ») en mélangeant des concepts anatomiques différents.6

- Intoxication réelle : un homme a souffert d’une intoxication au bromure après avoir suivi un « conseil diététique » inventé par ChatGPT, qui lui avait suggéré de remplacer le sel par du bromure de sodium.7

Enjeux de réputation et de confiance 🤝

Même dans des contextes moins critiques, les hallucinations peuvent gravement éroder la confiance des utilisateurs et la réputation des entreprises.

- Faux conseils et ridicule : en 2024, le chatbot d’Air Canada a par exemple donné de fausses informations sur les politiques de remboursement, menant à un jugement légal contre la compagnie.8 La même année, l’outil « AI Overviews » de Google a suggéré d’ajouter de la colle à la pizza ou de manger une pierre par jour, provoquant un ridicule public et même un sentiment de méfiance.9

- Dommages personnels : un homme norvégien a découvert que ChatGPT l’accusait d’avoir tué ses deux enfants10, une fausse allégation générée de toutes pièces, qui a causé un grave préjudice moral.

- Mauvais itinéraire : après la fin de l’événement caritatif ZEvent 2025, les vidéastes Byilhan et Nicotine se sont lancé le défi fou de rejoindre Paris depuis Montpellier à pied11. Au départ, ils ont consulté ChatGPT pour décider de leur itinéraire. Mais après quelques errances, ils ont changé de méthode : l’IA leur a fait faire des détours de plusieurs kilomètres !

Les causes profondes des hallucinations IA

Pourquoi ces erreurs persistent-elles ? Les hallucinations ne sont pas le fruit du hasard. Elles résulteraient d’un mélange de facteurs techniques et systémiques.

- La surconfiance des modèles : les LLM ont tendance à générer des réponses avec une grande certitude, même si l’information est fausse. Cette mauvaise calibration peut induire en erreur les utilisateurs professionnels qui s’attendent à une précision parfaite.

- La qualité des données : les LLM sont entraînés sur des masses de données d’Internet qui peuvent contenir des inexactitudes et des biais, ou même, être eux aussi générés par IA. Le modèle peut reproduire, voire amplifier, ces défauts.

- Les prompts ambigus : un prompt vague ou trop ouvert peut donner au modèle une liberté excessive, l’incitant à inventer des informations pour combler les lacunes de la requête.

- La nature probabiliste : les modèles fonctionnent en prédisant le mot le plus probable. Dans des cas complexes, cette prédiction peut s’éloigner de la vérité, d’autant plus que les paramètres de « température » qui contrôlent la créativité augmentent également le risque d’hallucinations.

La solution ? Pas de baguette magique, mais un écosystème hybride 🪄

Face à ces enjeux, la communauté scientifique et les entreprises reconnaissent que l’objectif n’est pas d’éradiquer totalement les hallucinations, mais de les réduire à un niveau gérable. La solution réside dans l’adoption d’une approche systémique, combinant technologies d’ancrage et supervision humaine.

- La Génération Augmentée par Récupération (RAG) : le RAG est devenu la principale stratégie pour les entreprises en 2025. Au lieu de s’appuyer uniquement sur ses connaissances internes, le RAG permet au modèle d’extraire des informations d’une base de connaissances fiable (souvent interne à l’entreprise) et de s’en servir comme contexte pour générer sa réponse. Cette méthode réduit considérablement les hallucinations. En effet, elle ancre les réponses dans des faits vérifiés et permet d’accéder à des données en temps réel. Le tout à moindre coût que le fine-tuning.

- Les Graphes de Connaissances (KGs) : pour les applications critiques, l’intégration des graphes de connaissances (GraphRAG) est une tendance majeure. Les KGs fournissent une représentation structurée et vérifiable du savoir. En les combinant avec le RAG, il est aussi possible d’atteindre une précision proche de 99 % dans les cas de recherche de faits.

- Garde-fous et supervision humaine : les « garde-fous » (guardrails) sont des systèmes qui imposent des limites opérationnelles. Ainsi, les sorties de l’IA sont conformes aux politiques, aux lois et aux exigences de l’entreprise. Ces mécanismes, combinés à la supervision humaine, sont plutôt essentiels pour les décisions à fort enjeu, où la précision doit être validée par un expert.

L’étude d’Open AI sur les hallucinations IA 🧪

Dans son étude Why Language Models Hallucinate parue le 4 septembre 2025, OpenAI a avancé une solution pour lutter contre les hallucinations de l’IA. L’entreprise estime que le problème ne réside pas dans la qualité des données d’entraînement, mais plutôt dans un système d’évaluation défectueux. Les modèles sont récompensés pour donner des réponses, même si elles sont fausses, et pénalisés pour admettre qu’ils ne savent pas. Cela les encourage à « deviner » pour obtenir de meilleurs scores, ce qui génère des erreurs plausibles et des informations inexactes.

La solution proposée par OpenAI est de modifier ce système d’évaluation pour qu’il récompense les modèles lorsqu’ils expriment leur incertitude, plutôt que de les pénaliser. En encourageant les modèles à dire « je ne sais pas » quand c’est approprié, OpenAI pense qu’il est possible de réduire considérablement les hallucinations et de créer des modèles linguistiques plus nuancés.

LabSense : la maîtrise de la génération de contenu sans hallucinations ! ✅

Produire du contenu à grande échelle, fiable et pertinent est effectivement notre métier depuis plus d’une décennie. Chez LabSense, nous avons fait de la lutte contre les hallucinations une priorité. Nous ne nous contentons pas de la simple génération de texte.

Notre méthode unique repose sur le « grounding » factuel pour garantir l’exactitude de chaque contenu. Nous intégrons par exemple les LLM à vos données internes et à des sources externes fiables via des API sécurisées. Qu’il s’agisse de vos fiches produits, de données clients, d’open data ou bien d’informations météorologiques, nous transformons une masse d’informations brutes en un contenu structuré et vérifié.

Avec plus de 10 ans de R&D et plus de 200 clients fidèles qui nous font confiance, notre approche ainsi combine la puissance de l’IA et une supervision humaine experte. Nos équipes travaillent en synergie avec l’IA pour corriger, affiner et garantir la qualité et la pertinence de chaque texte. De fait, ils éliminent de manière drastique le risque d’hallucination.

Nous ne produisons pas que du contenu, nous produisons de la confiance. Avec des solutions d’analyse, de correction et de génération en masse, nous avons déjà produit plus de 400 millions de textes.

💡Le saviez-vous ?

Les modèles Allready, la plateforme IA de LabSense, utilisent les derniers LLM de pointe et s’inspirent de l’agentivité. Ils peuvent vous aider à booster les performances de votre contenu, qu’il s’agisse d’annonces immobilières, d’articles ou de fiches produits. Les tester, c’est les adopter !

L’IA n’est pas un substitut, mais un catalyseur d’efficacité

L’augmentation des hallucinations de l’IA n’est pas une fatalité, mais un appel à l’action. L’enjeu n’est plus de créer des modèles toujours plus intelligents, mais des systèmes plus fiables. La confiance ne se gagne pas en augmentant le nombre de paramètres. Cependant, il faut mettre en place une méthodologie rigoureuse de vérification et de contextualisation.

Pour les entreprises, le chemin est donc clair : ne pas se contenter de l’IA « boîte noire ». Elles doivent exploiter des solutions qui combinent la puissance de la génération de langage avec la précision de vos propres données. C’est notamment en alimentant l’IA avec la richesse de vos bases de données produits, de vos informations clients, de l’open data ou de données météorologiques que l’on transforme une simple génération de texte en contenu vérifié et pertinent.

🚀 Besoin de produire en masse des contenus fiables et sans hallucinations IA ?

➡️ Contactez-nous et découvrez les solutions LabSense pour générer en masse votre contenu en toute confiance.

- Source : Article du journal Le Parisien par Jila Varoquier, « Désinformation : pourquoi l’IA est… de moins en moins fiable », 5 septembre 2025 || Lien ↩︎

- Source : Article Radio France par Julien Baldacchino, « Un avocat américain a utilisé ChatGPT pour préparer un procès… et n’a cité que des faux arrêts, 30 mai 2023 || Lien ↩︎

- Source : Article The Guardian, « Alabama paid a law firm millions to defend its prisons. It used AI and turned in fake citations », 24 mai 2025 || Lien ↩︎

- Source : Article Libération par Elise Viniacourt, « Aux Etats-Unis, une mère accuse une IA d’avoir poussé son fils de 14 ans au suicide », 24 octobre 2024 || Lien ↩︎

- Source : Medical Hallucination in Foundation Models and Their Impact on Healthcare, 28 février 2025 || Lien ↩︎

- Source : Article NextINpact par Martin Clavey, « Med-Gemini, l’IA médicale de Google, a halluciné des ganglions inexistants dans le cerveau », 27 août 2025 || Lien ↩︎

- Source : Article BFMTV par Théotim Raguet, « ChatGPT incite un utilisateur à s’empoisonner au brome », 13 août 2025 || Lien ↩︎

- Source : Article BizTech, « LLM Hallucinations: What Are the Implications for Financial Institutions? », 28 août 2025 || Lien ↩︎

- Source : Article BBC par Liv McMahon et Zoe Kleinman, « Glue pizza and eat rocks: Google AI search errors go viral », 24 mai 2024 || Lien ↩︎

- Source : Article du journal Le Monde, « L’ONG NOYB attaque OpenAI pour diffamation envers un citoyen norvégien, présenté à tort comme ayant tué deux de ses enfants », 20 mars 2025 || Lien ↩︎

- Source : Emission Popcorn du 9 septembre 2025, « Byilhan et Nico : leur folle aventure après le ZEVENT ! (Débrief ZEVENT 2025) » || Lien ↩︎